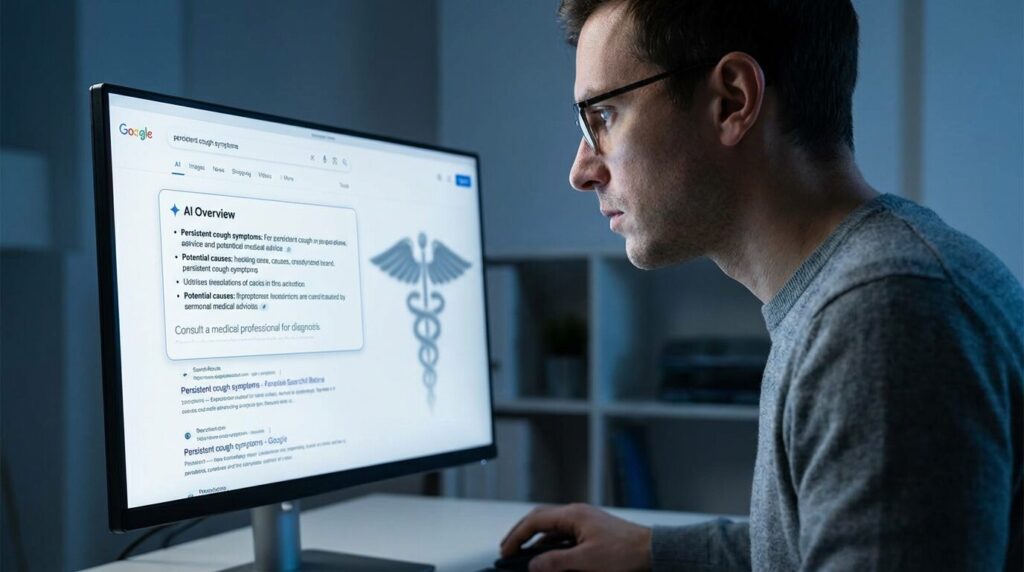

Představte si, že vyhledáte na Googlu příznaky, které vás trápí. Nahoře se objeví úhledný přehled vygenerovaný umělou inteligencí – vypadá autoritativně, odpovídá přesně na vaši otázku. Kliknete, přečtete si radu a jednáte podle ní. Jenže varování, že informace nemusí být správné a že byste měli navštívit lékaře, najdete až kdesi dole, malým písmem, po rozkliknutí tlačítka „Zobrazit více“. Přesně takhle to dnes funguje u AI Overviews od Googlu – a podle odborníků i pacientských organizací jde o nebezpečnou praxi.

Upozornění, které nikdo nevidí

Investigace britského deníku The Guardian odhalila, že Google sice tvrdí, že jeho AI přehledy uživatele vybízejí k vyhledání odborné pomoci, realita je ale jiná. Když poprvé dostanete zdravotní radu od umělé inteligence, žádné varování se neobjeví. Varování se ukáže až tehdy, pokud si vyžádáte další informace – a i pak je schované na konci textu, menším a světlejším písmem.

„Toto je pouze pro informační účely. Pro lékařskou radu nebo diagnózu se obraťte na odborníka. Odpovědi AI mohou obsahovat chyby,“ stojí v upozornění, které většina uživatelů nikdy neuvidí. Google na kritiku reagoval tvrzením, že varování se často objevují přímo v textu přehledu „když je to vhodné“ – jenže jak ukazují zjištění The Guardian, praxe je od teorie daleko.

Halucinace s reálnými následky

Pat Pataranutaporn z MIT označil absenci viditelných varování za „kriticky nebezpečnou“. Problém není jen v tom, že AI modely stále „halucinují“ – tedy vymýšlejí si informace – ale také v lidském faktoru. Uživatelé nemusí poskytnout všechny potřebné informace nebo špatně popsat příznaky. Právě proto jsou podle něj disclaimery klíčové: „Narušují automatickou důvěru a nutí uživatele přemýšlet kriticky.“

Gina Neff z Queen Mary University v Londýně jde ještě dál: „Problém se špatnými AI přehledy je daný designem. Google je navrhuje pro rychlost, ne pro přesnost – a to vede k chybám ve zdravotních informacích, které mohou být nebezpečné.“

V lednu přitom The Guardian odhalil, že AI Overviews skutečně poskytovaly nepřesné a zavádějící zdravotní rady. Google v reakci některé přehledy odstranil – ale ne všechny.

Iluze úplné odpovědi

Sonali Sharma ze Stanfordova centra pro AI v medicíně upozorňuje na další past: AI přehledy se objevují úplně nahoře ve výsledcích vyhledávání a často působí jako kompletní odpověď. „To vytváří pocit jistoty, který lidi odrazuje od dalšího hledání nebo proklikávání k disclaimeru,“ vysvětluje. Největší riziko vidí v tom, že informace bývají částečně správné a částečně chybné – a rozlišit je dokáže jen ten, kdo se v problematice už vyzná.

Tom Bishop z britské charitativní organizace Anthony Nolan volá po okamžité změně: „Varování musí být mnohem výraznější. Mělo by být první, co uvidíte, stejně velkým písmem jako zbytek textu – ne něco malého, co snadno přehlédnete.“

V českém prostředí hledá zdravotní informace na internetu až 95 % lidí. AI Overviews sice zatím nejsou v Česku plně nasazeny, ale je jen otázkou času, kdy se tak stane. Google tvrdí, že „drtivá většina přehledů poskytuje přesné informace“ a že neustále pracuje na zlepšování. Jenže i kdyby měl pravdu v 95 % případů, zbývajících pět procent může znamenat reálné zdravotní komplikace pro miliony uživatelů po celém světě.

Možná by stálo za to položit si otázku: Chceme opravdu, aby nás léčila umělá inteligence, která své vlastní omyly přiznává jen malým písmem?

Zdroj info: The Guardian

Autor: Petr Poreba

Foto: Vytvořeno umělou inteligencí v ChatGPT

<